人工智能(artificial intelligence)[1],按照維基百科定義,指由人工制造出來(lái)的系統(tǒng)所表現(xiàn)出來(lái)的智能。這里的人工制造的系統(tǒng),具體到安防領(lǐng)域,指的就是智能算法。其實(shí)現(xiàn)在安防領(lǐng)域中的大多數(shù)設(shè)備,比如支持移動(dòng)偵測(cè)的IPC、智能分析服務(wù)器、視頻濃縮和視頻摘要服務(wù)器、非現(xiàn)場(chǎng)執(zhí)法設(shè)備、卡口型攝像機(jī),等等,都實(shí)現(xiàn)著人工智能算法。所以,人工智能應(yīng)用于安防領(lǐng)域,并不是一個(gè)新鮮話題。

人工智能學(xué)科主要研究算法的以下幾個(gè)方面的能力:演繹(deduction)和推理(reasoning)、知識(shí)表示(knowledgerepresentation)、規(guī)劃(planning)、學(xué)習(xí)(learning)、自然語(yǔ)言處理(naturallanguage processing)、運(yùn)動(dòng)和控制(motionand manipulation)、感知(perception)、社交智能(social intelligence)、創(chuàng)造力(creativity)、通用智能(generalintelligence)。

人工智能學(xué)科主要的研究方法有:控制論和腦模擬(cybernetics and brainsimulation),符號(hào)法(symbolic):又含有認(rèn)知模擬(cognitive simulation)法、基于邏輯(logic-based)法、基于知識(shí)(knowledgebased)法、子符號(hào)(sub-symbolic)法、統(tǒng)計(jì)學(xué)(statistical)法、集成方法(Integratingthe approaches)。

人工智能學(xué)科主要的工具有:搜索和優(yōu)化(search and optimization)、邏輯(logic)、不確定推理的概率法(probabilisticmethods for uncertain reasoning)、分類和統(tǒng)計(jì)學(xué)習(xí)法(classifiers and statisticallearning methods)、神經(jīng)網(wǎng)絡(luò)(Neuralnetworks)、深度前饋神經(jīng)網(wǎng)絡(luò)(deepfeedforward neural networks)、深度遞歸神經(jīng)網(wǎng)絡(luò)(deep recurrent neuralnetworks)、控制論(control theory)。

深度學(xué)習(xí)興起

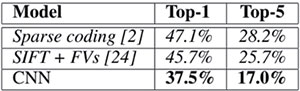

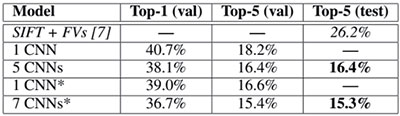

2012年,多倫多大學(xué)Geoff Hinton的兩個(gè)博士生Alex Krizhevsky 和IlyaSutskever 在NIPS 上發(fā)表論文《ImageNetClassification with Deep ConvolutionalNeural Networks》[2],采用深度卷積網(wǎng)絡(luò)算法,在圖片分類競(jìng)賽ImageNet 中的大規(guī)模視覺(jué)識(shí)別挑戰(zhàn)賽ILSVRC-2010和ILSVRC-2012上(如圖1和圖2所示),圖片分類結(jié)果均拿到了第一名,并且相比于傳統(tǒng)的手工特征的最好的算法(SIFT+Fisher Vectors)的分類結(jié)果(top-1錯(cuò)誤率和top 錯(cuò)誤率)減少近10% !(注圖1和圖2中斜體為最好的手工特征算法結(jié)果,粗體為CNN 結(jié)果,帶星號(hào)的為神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)經(jīng)過(guò)“預(yù)訓(xùn)練”了的分類結(jié)果)要知道,在過(guò)去競(jìng)賽中,使用傳統(tǒng)手工特征的形形色色算法的結(jié)果提升幅度從沒(méi)有這么高。可想而知,這在計(jì)算機(jī)視覺(jué)(computer vision)領(lǐng)域引起地震。同時(shí)也拉開了CNN 在計(jì)算機(jī)視覺(jué)領(lǐng)域以及其他領(lǐng)域大量運(yùn)用,以及CNN網(wǎng)絡(luò)結(jié)構(gòu)快速發(fā)展的大幕。

圖1 引文[2]中的ILSVRC-2010中的DCNN和傳統(tǒng)手工特征算法圖片分類結(jié)果對(duì)比

圖2 引文[2]中的ILSVRC-2012中的DCNN和最好的傳統(tǒng)手工特征算法圖片分類結(jié)果對(duì)比

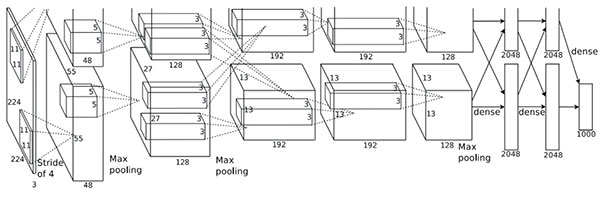

卷積神經(jīng)網(wǎng)絡(luò)并不是個(gè)新鮮算法,在20世紀(jì)曾經(jīng)經(jīng)歷過(guò)一段時(shí)期的冷遇,根因是卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練過(guò)程收斂前需要反復(fù)迭代前向傳播和反向傳播,計(jì)算量超多,使用現(xiàn)在速度最快的多核CPU 架構(gòu),訓(xùn)練時(shí)間也要幾十天。NVIDIA 的GPU 中的數(shù)以千計(jì)的計(jì)算單元陣列的快速發(fā)展有效的解決了這一問(wèn)題,大大縮短了訓(xùn)練周期。如圖3所示為論文中使用的CNN 訓(xùn)練結(jié)構(gòu),該網(wǎng)絡(luò)人們習(xí)慣上稱為AlexNet。

同時(shí)隨著網(wǎng)絡(luò)中的連接數(shù)(參數(shù))的增多,需要的訓(xùn)練數(shù)據(jù)也越多,比如ImageNetLSVRC-2010就含有1000多個(gè)種類的120多萬(wàn)張的圖片。

圖3引文[2]使用的由兩個(gè)GPU分擔(dān)的CNN結(jié)構(gòu)圖

由此可見,GPU 的高速發(fā)展以及海量數(shù)據(jù)的出現(xiàn),使得深度神經(jīng)網(wǎng)絡(luò)訓(xùn)練變得可行,加速了深度神經(jīng)網(wǎng)絡(luò)在計(jì)算機(jī)視覺(jué)、語(yǔ)音、文本、自然語(yǔ)言處理等領(lǐng)域的快速普及。

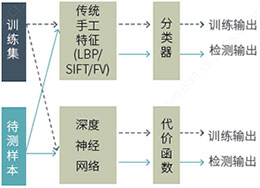

深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一個(gè)分支。機(jī)器學(xué)習(xí)的目的是根據(jù)在訓(xùn)練數(shù)據(jù)集上每個(gè)樣本的目標(biāo)值,學(xué)習(xí)得到一個(gè)模型。訓(xùn)練時(shí),對(duì)分類器輸出和目標(biāo)值進(jìn)行對(duì)比,根據(jù)使用的分類器和代價(jià)函數(shù)(或損失函數(shù),lossfunction),使用優(yōu)化算法,反復(fù)迭代,不斷調(diào)整參數(shù),直到算法收斂為止。檢測(cè)時(shí)使用該模型用于新的樣本,模型的輸出就是我們需要的輸出。如圖4所示。相比于檢測(cè)過(guò)程(或測(cè)試過(guò)程),訓(xùn)練過(guò)程需要反復(fù)迭代,運(yùn)算量極大。傳統(tǒng)手工設(shè)計(jì)特征的表現(xiàn)能力遠(yuǎn)遠(yuǎn)不及神經(jīng)網(wǎng)絡(luò)的抽象表達(dá)能力。這就是神經(jīng)網(wǎng)絡(luò),尤其是深度神經(jīng)網(wǎng)絡(luò)的優(yōu)勢(shì)所在。

目標(biāo)值為連續(xù)實(shí)數(shù)時(shí),會(huì)學(xué)習(xí)得到一個(gè)回歸器(regressor),目標(biāo)值為離散值時(shí)該機(jī)器學(xué)習(xí)問(wèn)題為分類。不過(guò)有時(shí)把回歸和分類問(wèn)題合在一起訓(xùn)練。

圖4 神經(jīng)網(wǎng)絡(luò)相比手工設(shè)計(jì)特征具有更強(qiáng)的特征表現(xiàn)力

雖然理論界無(wú)法對(duì)深度神經(jīng)網(wǎng)絡(luò)如此強(qiáng)大的特征表達(dá)能力給出令人信服的理論推導(dǎo),但是它在實(shí)踐應(yīng)用中的卓越表現(xiàn)極大刺激了它在各個(gè)領(lǐng)域的快速推廣。ImageNet 2016 屆大規(guī)模視覺(jué)識(shí)別挑戰(zhàn)賽(ILSVRC-2016)結(jié)果剛剛公布,在各個(gè)比賽中獲得第一名的團(tuán)隊(duì)采用的算法均是基于深度神經(jīng)網(wǎng)絡(luò)的。

神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

神經(jīng)網(wǎng)絡(luò)一般含有輸入層、隱含層、輸出層。

若含有多個(gè)或者很多個(gè)隱含層,則成為深度神經(jīng)網(wǎng)絡(luò)或者甚深神經(jīng)網(wǎng)絡(luò),到底多少個(gè)隱含層算深,其實(shí)在學(xué)術(shù)界并沒(méi)有嚴(yán)格的定義。

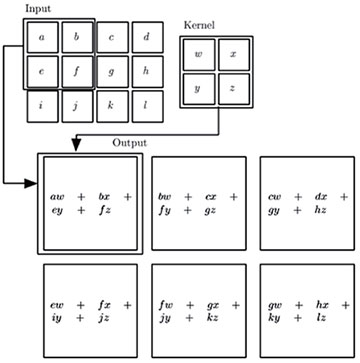

屬于卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks 或CNN)家族的各種結(jié)構(gòu)神經(jīng)網(wǎng)絡(luò)主要用于處理網(wǎng)格結(jié)構(gòu)數(shù)據(jù),比如時(shí)間序列數(shù)據(jù)(音頻)可以看成為按照一定時(shí)間間隔采樣而成的1D 網(wǎng)格數(shù)據(jù);圖像可以看成由像素組成的3D 網(wǎng)格數(shù)據(jù);視頻可以看成是由按照時(shí)間采樣的2D 圖像組成的3D 網(wǎng)格數(shù)據(jù);視頻和光流可以是由2D 圖像加1D 光流按照時(shí)間采樣的4D 網(wǎng)格數(shù)據(jù);等等。卷積神經(jīng)網(wǎng)絡(luò)主要的操作就是卷積,如圖5 [3] 所示為2D 卷積原理示意圖。卷積操作主要實(shí)現(xiàn)了稀疏交互(sparse interactions)、參數(shù)共享(parameter sharing)、等變表示(equivariantrepresentations)三種思想。卷積網(wǎng)絡(luò)的一個(gè)層典型的具有三個(gè)階段,首先是執(zhí)行卷積操作產(chǎn)生一個(gè)線性激勵(lì)(activation);然后是每個(gè)線性激勵(lì)執(zhí)行一個(gè)非線性激勵(lì)函數(shù),比如校正的線性激勵(lì)(rectified linearactivation),這一階段有時(shí)稱為檢測(cè)(detector)階段;第三階段,使用池化(pooling,或匯聚)操作進(jìn)一步修改層的輸出,即減少特征映射平面(feature map plane)中特征數(shù)目。

在安防領(lǐng)域大量應(yīng)用的對(duì)象檢測(cè)、對(duì)象跟蹤、對(duì)象識(shí)別等應(yīng)用都是基于卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)。

圖5 2D卷積操作示意圖

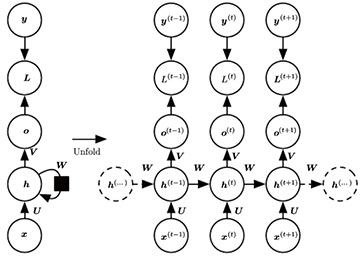

遞歸神經(jīng)網(wǎng)絡(luò)(Recurrentneural networks/ RNN)家族中各種結(jié)構(gòu)神經(jīng)網(wǎng)絡(luò)主要用于處理序列化數(shù)據(jù),所以一般認(rèn)為遞歸神經(jīng)網(wǎng)絡(luò)對(duì)歷史數(shù)據(jù)具有記憶性,即網(wǎng)絡(luò)對(duì)當(dāng)前輸入計(jì)算輸出時(shí),既考慮當(dāng)前的輸入,由考慮歷史輸入。如圖6所示,左邊為未展開的遞歸神經(jīng)網(wǎng)絡(luò)原理示意圖,右邊的為展開(unfold)后的遞歸神經(jīng)網(wǎng)絡(luò)原理示意圖。輸入序列為x,輸出序列為o,y 為目標(biāo)輸出,L為損失函數(shù),h為內(nèi)部狀態(tài),W 為網(wǎng)絡(luò)連接權(quán)值。通過(guò)圖6右側(cè)看出,網(wǎng)絡(luò)內(nèi)部狀態(tài)h 隨著時(shí)間發(fā)生變化,不同于卷積神經(jīng)網(wǎng)絡(luò),訓(xùn)練完畢后,網(wǎng)絡(luò)狀態(tài)處于靜止?fàn)顟B(tài),不會(huì)隨著輸入的變化而變化。

圖6遞歸神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)示意圖

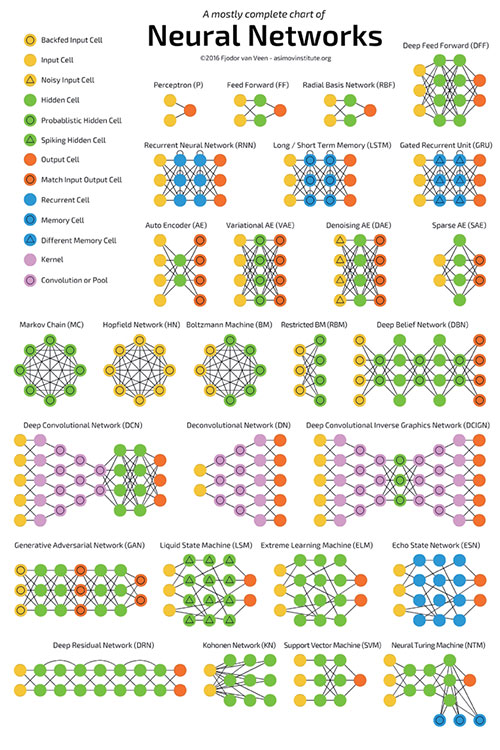

除了這兩種主要的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)外,其實(shí)還有很多各種各樣的網(wǎng)絡(luò)結(jié)構(gòu),如圖7[4] 所示。

圖7神經(jīng)網(wǎng)絡(luò)匯總[4]

神經(jīng)網(wǎng)絡(luò)發(fā)展現(xiàn)狀

目前人類在腦科學(xué)方面對(duì)人腦的真正的工作機(jī)理還沒(méi)有完全弄懂。深度神經(jīng)網(wǎng)絡(luò),并不是嚴(yán)格意義上的類人腦計(jì)算,只是根據(jù)腦神經(jīng)科學(xué)初期的研究成果,在一定程度上受到人腦信息處理機(jī)制的啟發(fā),模擬一些人腦細(xì)胞的工作構(gòu)成網(wǎng)絡(luò),其本質(zhì)上還是一些類似于支撐向量機(jī)、隱式馬爾科夫鏈之類的機(jī)器學(xué)習(xí)模型。比如Facebook FIR 的LeCunYann 就曾經(jīng)說(shuō)過(guò),卷積神經(jīng)網(wǎng)絡(luò)嚴(yán)格講應(yīng)為卷積網(wǎng)絡(luò)(convolutional networks),之所以去掉“神經(jīng)”二字就是為避免人們誤解。但由于歷史原因,以及一些學(xué)術(shù)論文的宣傳目的,大都冠以“神經(jīng)”二字,但目前在人類還未完全弄懂人腦全部工作機(jī)理的前提下,是不可能構(gòu)造真正類似人腦一樣的神經(jīng)網(wǎng)絡(luò)。

深度神經(jīng)網(wǎng)絡(luò)相比傳統(tǒng)方法具有更強(qiáng)的特征表達(dá)能力,但它并不是萬(wàn)能的,也并不是適用于所有的問(wèn)題。同時(shí)深度神經(jīng)網(wǎng)絡(luò)訓(xùn)練需要數(shù)據(jù)量足夠大,若數(shù)據(jù)量不夠大會(huì)導(dǎo)致過(guò)擬合,神經(jīng)網(wǎng)絡(luò)的優(yōu)勢(shì)就體現(xiàn)不出來(lái)。

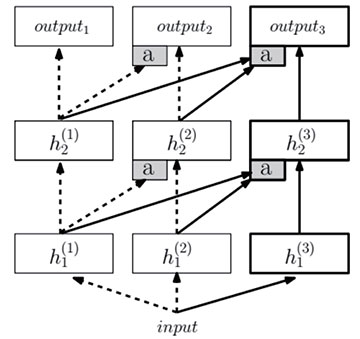

但是在一些方面,深度神經(jīng)網(wǎng)絡(luò)確實(shí)有比人腦有更強(qiáng)大的地方,比如深度神經(jīng)網(wǎng)絡(luò)可以具有海量的內(nèi)存存儲(chǔ)能力,輕松把人腦無(wú)法記憶的許多數(shù)據(jù)存儲(chǔ)起來(lái)進(jìn)行檢索。目前情況是,使用一個(gè)類型的數(shù)據(jù)集訓(xùn)練得到的深度神經(jīng)網(wǎng)絡(luò)不能對(duì)其他類型的數(shù)據(jù)進(jìn)行應(yīng)用,神經(jīng)網(wǎng)絡(luò)的功能單一,還無(wú)法跨領(lǐng)域?qū)W習(xí);但是人腦可以在不同應(yīng)用領(lǐng)域輕松的實(shí)現(xiàn)跨域聯(lián)想,可以在數(shù)學(xué)領(lǐng)域借鑒音樂(lè)美術(shù)等藝術(shù)領(lǐng)域的一些思想火花。在圍棋戰(zhàn)勝李世石的AlphaGo 并不會(huì)下簡(jiǎn)單的象棋或者軍棋,但是人腦可以輕松的進(jìn)行類似思維切換。所以近期google 的Raia Hadsell 團(tuán)隊(duì)使用連接的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)實(shí)驗(yàn)這種可以實(shí)現(xiàn)思維切換的通用人工智能(general artificialintelligence):進(jìn)步神經(jīng)網(wǎng)絡(luò)(progressiveneural networks)[5],就是想打破這種功能限制,在神經(jīng)網(wǎng)絡(luò)的通用性上進(jìn)行探索。如圖8 所示,一個(gè)三列進(jìn)步神經(jīng)網(wǎng)絡(luò)示意圖,左邊的兩列(虛箭頭)分別在任務(wù)1 和任務(wù)2 上進(jìn)行訓(xùn)練,標(biāo)a 的灰色框表示適應(yīng)層(adapterlayers),附加上右邊的第三列用于任務(wù)3,可以訪問(wèn)前面已經(jīng)學(xué)習(xí)到的所有特征。

圖8 進(jìn)步神經(jīng)網(wǎng)絡(luò)

探索道路上人類才邁出了一小步,到底什么時(shí)候會(huì)真正探索到真理不得而知。如LeCunYann 就曾指出,現(xiàn)在大量使用的深度學(xué)習(xí)模型都是使用監(jiān)督學(xué)習(xí)的方式,但是人腦的學(xué)習(xí)方式是無(wú)監(jiān)督的。學(xué)者們?cè)跓o(wú)監(jiān)督學(xué)習(xí)的探索才剛剛開始。

雖然神經(jīng)網(wǎng)絡(luò)還處于發(fā)展初期,但表現(xiàn)出的超強(qiáng)能力,尤其自動(dòng)駕駛、輔助駕駛方面的能力在全球各地有大量的實(shí)驗(yàn)以及應(yīng)用。

比如最近美國(guó)國(guó)家交通部就正式發(fā)布針對(duì)自動(dòng)駕駛汽車(self-driving cars/ automatedvehicles)的征求意見稿,美國(guó)前總統(tǒng)奧巴馬還專門發(fā)表講話[6] 把自動(dòng)駕駛作為高新產(chǎn)業(yè)在美國(guó)的快速規(guī)范發(fā)展。自動(dòng)駕駛汽車類似于機(jī)器人,集成了大多數(shù)的人工智能技術(shù),自動(dòng)駕駛技術(shù)的發(fā)展會(huì)極大促進(jìn)整個(gè)人工智能技術(shù)的發(fā)展。

由于媒體和人工智能廠商的肆意夸大宣傳,導(dǎo)致非專業(yè)人們對(duì)深度神經(jīng)網(wǎng)絡(luò)產(chǎn)生很多誤解,甚至引起恐慌,這些都是完全沒(méi)有必要的。比如2016 年9 月,特斯拉在中國(guó)的一次車禍中,23 歲駕駛者駕駛一輛Model S 撞向路中間的道路清掃車致死。死者父親接受采訪時(shí)表示[7],他兒子一直信賴自動(dòng)駕駛,因此在事故發(fā)生時(shí)并沒(méi)有在觀察路面情況。事故發(fā)生后,特斯拉在其中文網(wǎng)站中去掉了“自動(dòng)駕駛”這個(gè)詞。同時(shí)特斯拉表示,自動(dòng)駕駛系統(tǒng)不是為了徹底取代駕駛員,打開自動(dòng)駕駛后,駕駛員會(huì)受到語(yǔ)音和文字告警,迫使駕駛員將雙手放在方向盤上,并注意路面情況。

但是某些媒體把這種需要駕駛員協(xié)助的自動(dòng)駕駛吹噓成無(wú)人駕駛,這極大誤解了人工智能技術(shù),對(duì)技術(shù)的發(fā)展以及產(chǎn)業(yè)的發(fā)展都不會(huì)有好處,當(dāng)達(dá)不到宣傳的預(yù)期效果時(shí),反而會(huì)給消費(fèi)者產(chǎn)生不信任的印象。

目前已經(jīng)應(yīng)用或者打算應(yīng)用的自動(dòng)駕駛汽車案例(優(yōu)步攜手沃爾沃將在美國(guó)匹茲堡提供無(wú)人駕駛叫車服務(wù),以及新創(chuàng)公司NuTonomy 的無(wú)人自駕計(jì)程車在新加坡緯壹科技城商業(yè)區(qū)投入運(yùn)營(yíng))都必須在限制的場(chǎng)景。目前來(lái)看,還無(wú)法實(shí)現(xiàn)能夠在各種場(chǎng)景中的真正的自動(dòng)駕駛,人工智能在某些領(lǐng)域很難達(dá)到人類水平的智能。

神經(jīng)網(wǎng)絡(luò)在安防行業(yè)中的應(yīng)用現(xiàn)狀

自從2012年AlexNet 發(fā)布后,和人工智能相關(guān)的眾多學(xué)科的研究人員把深度神經(jīng)網(wǎng)絡(luò)用于自己的研究領(lǐng)域,都取得了豐碩成果。安防行業(yè)主要與圖像視頻應(yīng)用相關(guān),其中最主要的研究方向有:圖片或視頻中的對(duì)象檢測(cè)(object detection)、圖片或視頻中的對(duì)象定位(object localization)、基于視頻的目標(biāo)跟蹤(object tracking)、基于圖片或視頻場(chǎng)景分類(scene classification)、基于圖片或視頻的場(chǎng)景解析(scene parsing)、基于圖片或視頻的目標(biāo)行為識(shí)別(activityrecognition)。用于圖像分類和檢測(cè)應(yīng)用的深度神經(jīng)網(wǎng)絡(luò),AlexNet 后又出現(xiàn)了牛津大學(xué)的VGGNet,谷歌的GooLeNe(t Inception-v1、Inception-v2、Inception-v3、Inception-v4)以及后微軟的ResNet(Resnet1、Resnet2),還有這兩種結(jié)構(gòu)結(jié)合后形成的Inception-ResNet、Inception-ResNet-v2。短短4年時(shí)間里,學(xué)術(shù)研究在積極探索著引領(lǐng)著網(wǎng)絡(luò)結(jié)構(gòu)的快速發(fā)展,同時(shí)產(chǎn)業(yè)界也積極把學(xué)術(shù)界的研究成果引入的各自的產(chǎn)品當(dāng)中,并且結(jié)合產(chǎn)品應(yīng)用的實(shí)際場(chǎng)景,對(duì)網(wǎng)絡(luò)模型進(jìn)行優(yōu)化和增量訓(xùn)練,取得了卓越的效果。比如宇視科技的智能識(shí)別服務(wù)器IA8500-FA和IA9600-FS,視頻摘要和視頻濃縮服務(wù)器IA8500-VI、IA8800-VI、IA8800-VIM,都已經(jīng)使用NVIDIA 公司新款GPU,同時(shí)配置卓越的深度神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),在各項(xiàng)檢測(cè)和識(shí)別指標(biāo)上在業(yè)界都達(dá)到了優(yōu)秀水平。

在安防行業(yè)的分布式計(jì)算以及大數(shù)據(jù)挖掘方面,將來(lái)也會(huì)涌現(xiàn)出大量的創(chuàng)新與應(yīng)用。對(duì)深度神經(jīng)網(wǎng)絡(luò)應(yīng)用來(lái)說(shuō),網(wǎng)絡(luò)結(jié)構(gòu)與模型、實(shí)現(xiàn)代碼已經(jīng)變得不再重要。不同于傳輸?shù)闹悄芩惴ㄩ_發(fā),單憑一家力量很難取得優(yōu)異的結(jié)果。海量數(shù)據(jù)或者說(shuō)大數(shù)據(jù)變得比網(wǎng)絡(luò)結(jié)構(gòu)和代碼變得更重要!同時(shí)必須借助開源力量共同推進(jìn)發(fā)展。所以在業(yè)界,尤其是學(xué)術(shù)以及行業(yè)領(lǐng)導(dǎo)者(google、facebook FAIR、美國(guó)紐約大學(xué)LeCunYann 團(tuán)隊(duì)、加拿大蒙特利爾大學(xué)Geoffrey E. Hinton 團(tuán)隊(duì)、百度的前吳恩達(dá)團(tuán)隊(duì)),紛紛開源自己的各種項(xiàng)目的代碼,借助同行業(yè)的力量推動(dòng)發(fā)展,同時(shí)建立在領(lǐng)域內(nèi)的領(lǐng)導(dǎo)地位。

人工智能在安防行業(yè)應(yīng)用展望

在安防行業(yè),目前人工智能算法使用最多的還是在視頻圖像領(lǐng)域,因?yàn)閭鹘y(tǒng)的安防企業(yè)的產(chǎn)品都是與視頻圖像相關(guān)。但對(duì)于有些業(yè)務(wù)應(yīng)用來(lái)說(shuō),視頻圖像只是一小部分,還需要網(wǎng)絡(luò)信息、通信信息、社交信息,等等。將來(lái)安防行業(yè)還需要以視頻圖像信息為基礎(chǔ),打通各種異構(gòu)信息,在海量異構(gòu)信息的基礎(chǔ)上,充分發(fā)揮機(jī)器學(xué)習(xí)、數(shù)據(jù)分析與挖掘等各種人工智能算法的優(yōu)勢(shì),為安防行業(yè)創(chuàng)造更多價(jià)值。

參考文獻(xiàn)

[1]https://en.wikipedia.org/wiki/Artificial_intelligence

[2]http://papers.nips.cc/paper/4824-imagenet-classification-with-deepconvolutional-neural-networks

[3]http://www.deeplearningbook.org/

[4]http://www.asimovinstitute.org/neural-network-zoo/

[5]http://arxiv.org/abs/1606.04671

[6]http://www.post-gazette.com/opinion/Op-Ed/2016/09/19/Barack-Obama-Self-driving-yes-but-also-safe/stories/201609200027

[7]http://m.cn.nytimes.com/technology/20160918/fatal-tesla-crash-in-china-involved-autopilotgovernment-tv-says/

浙公網(wǎng)安備 33010802004032號(hào)

浙公網(wǎng)安備 33010802004032號(hào)